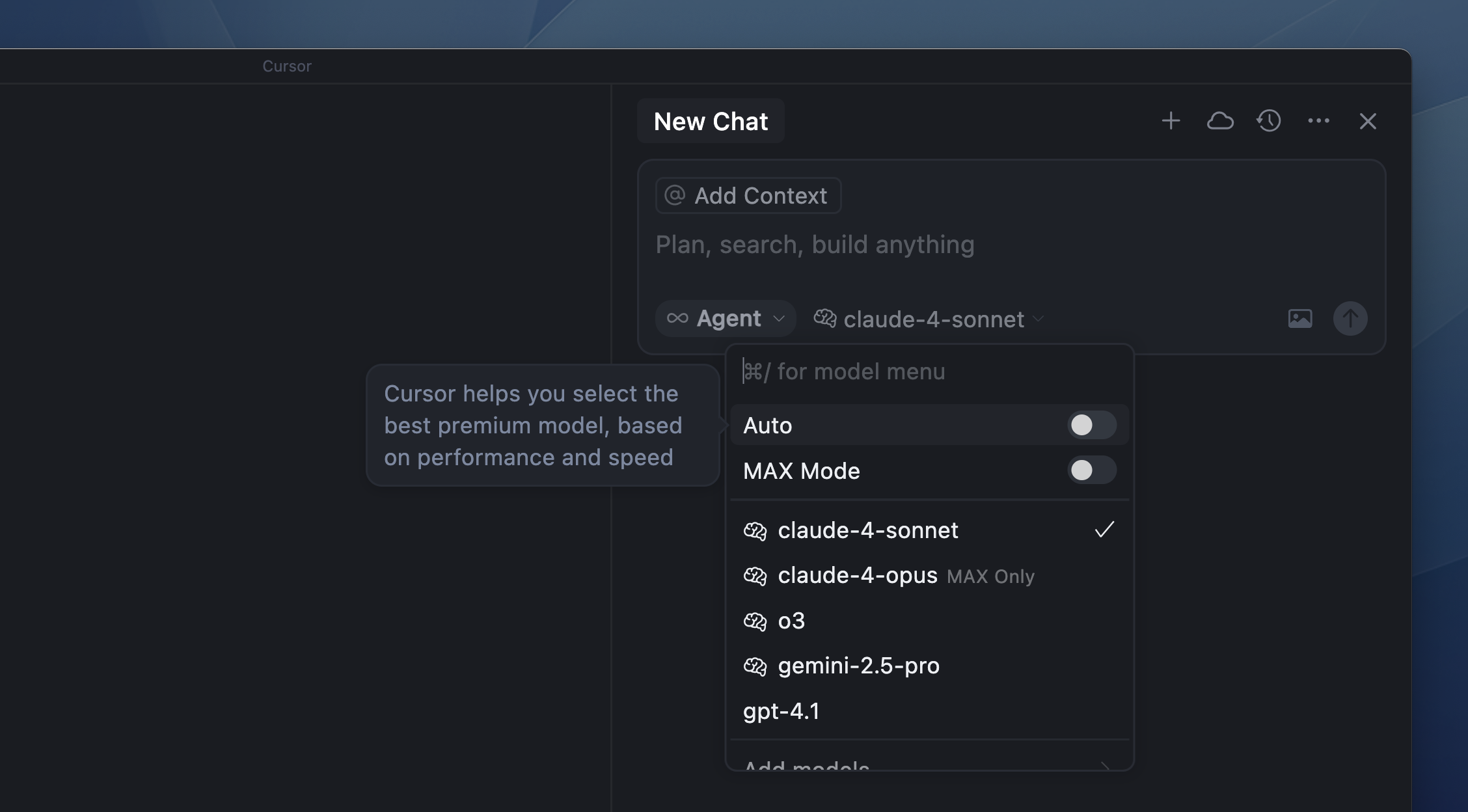

Tarification des modèles

Auto

Fenêtres de contexte

Mode Max

FAQ

Où les modèles sont-ils hébergés ?

Où les modèles sont-ils hébergés ?

Les modèles sont hébergés sur une infrastructure située aux États‑Unis, par le fournisseur du modèle, un partenaire de confiance ou directement par Cursor.Quand le mode Confidentialité est activé, ni Cursor ni les fournisseurs de modèles ne conservent tes données. Toutes les données sont supprimées après chaque requête. Pour plus de détails, consulte nos pages Confidentialité, Politique de confidentialité et Sécurité.