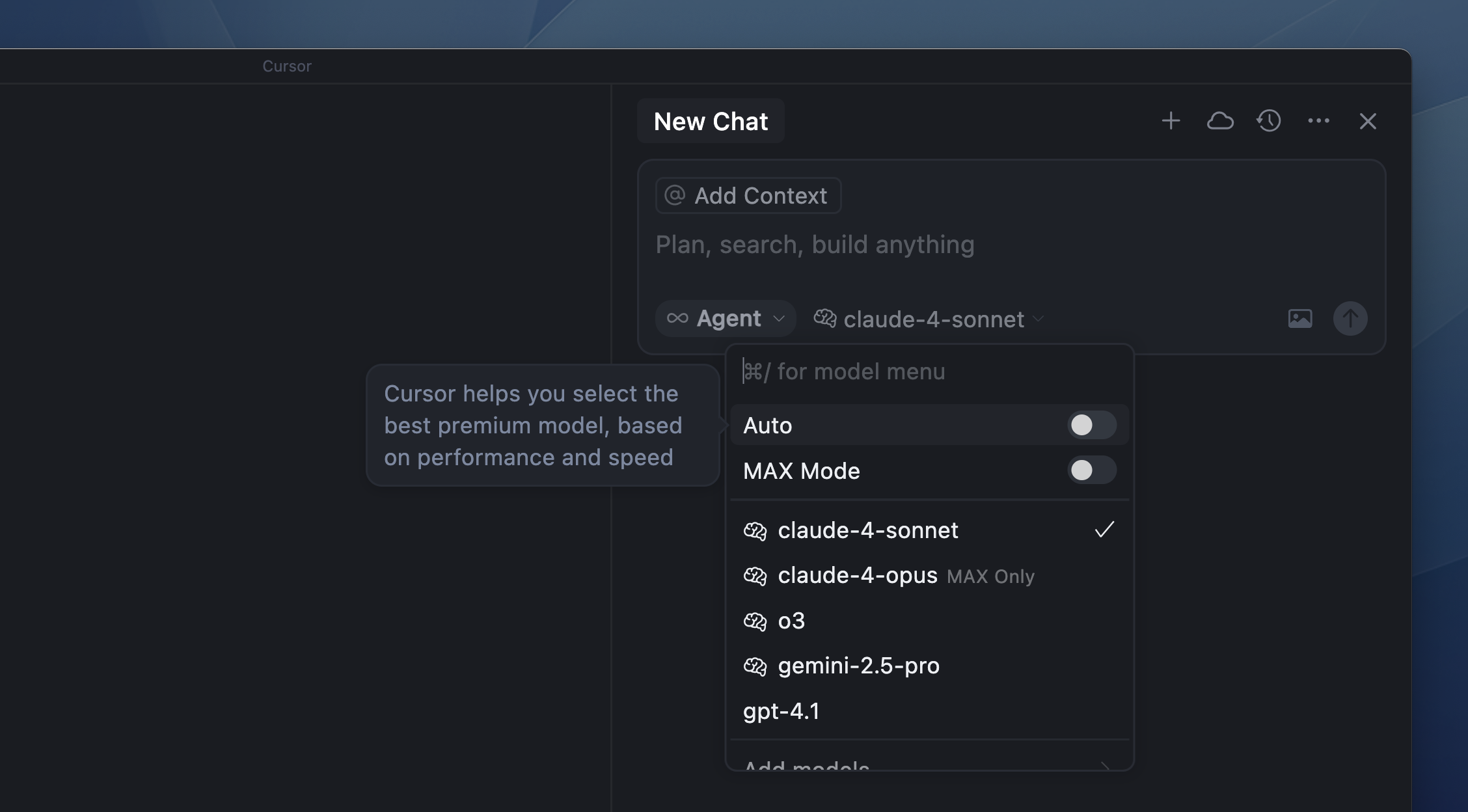

Precios de modelos

Auto

Ventanas de contexto

Max Mode

Preguntas frecuentes

¿Dónde están alojados los modelos?

¿Dónde están alojados los modelos?

Los modelos se alojan en infraestructura ubicada en EE. UU. por el proveedor del modelo, un socio de confianza o directamente por Cursor.Cuando el Modo de privacidad está activado, ni Cursor ni los proveedores de modelos almacenan tus datos. Todos los datos se eliminan después de cada solicitud. Para más detalles, consulta nuestras páginas de Privacidad, Política de privacidad y Seguridad.