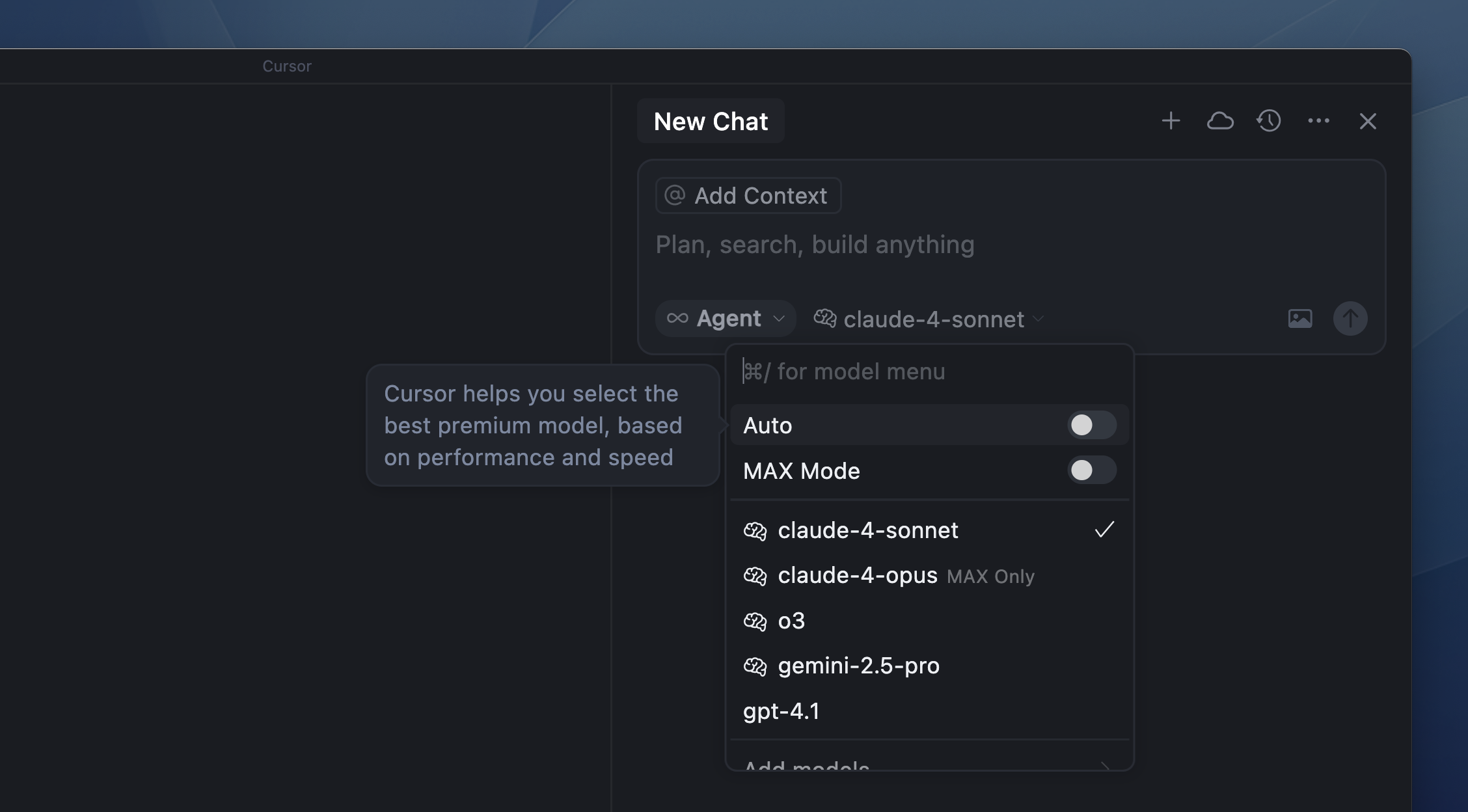

Preços dos modelos

Auto

Janelas de contexto

Modo Max

FAQ

Onde os modelos são hospedados?

Onde os modelos são hospedados?

Os modelos são hospedados em infraestrutura nos EUA pelo provedor do modelo, por um parceiro confiável ou diretamente pelo Cursor.Quando o Modo de Privacidade está ativado, nem o Cursor nem os provedores de modelos armazenam teus dados. Todos os dados são apagados após cada requisição. Para mais detalhes, confere nossas páginas de Privacidade, Política de Privacidade e Segurança.