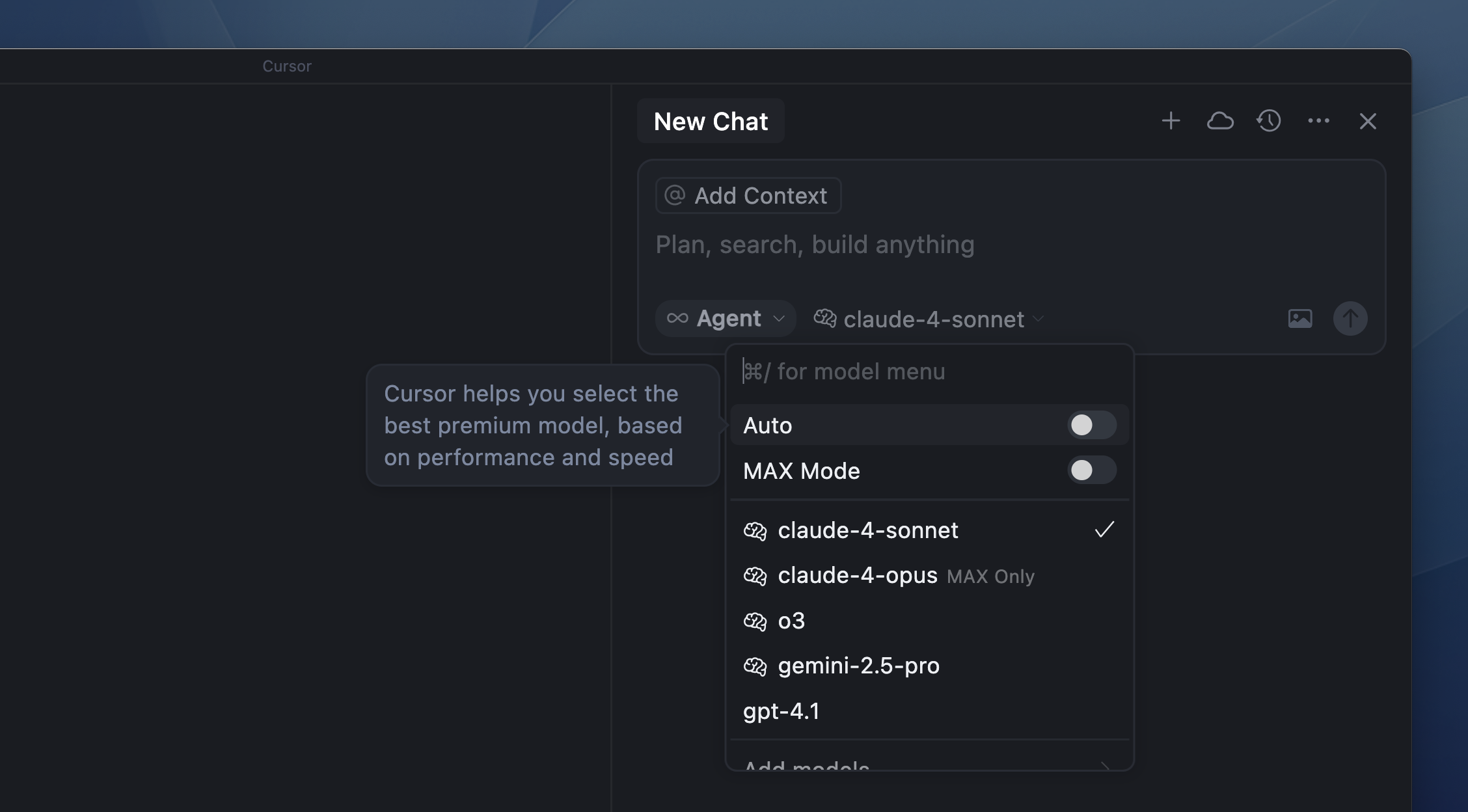

Modellpreise

Auto

Kontextfenster

Max Mode

FAQ

Wo werden Modelle gehostet?

Wo werden Modelle gehostet?

Modelle werden auf US-amerikanischer Infrastruktur gehostet – entweder vom jeweiligen Anbieter, einem vertrauenswürdigen Partner oder direkt von Cursor.Wenn der Privacy Mode aktiviert ist, speichern weder Cursor noch die Modellanbieter deine Daten. Alle Daten werden nach jeder Anfrage gelöscht. Details findest du auf unseren Seiten Privacy, Privacy Policy und Security.